# CouranD #58 - Trainen en zoeken

Over de rechten rondom trainingsdata en de toekomst van zoeken op Google

Given the profound transformative impact AI will have on our societies and economies, the AI Act is very likely the most important piece of legislation in this mandate. It’s the first piece of legislation of this kind worldwide, which means that the EU can lead the way in making AI human-centric, trustworthy and safe. - Dragos Tudorache in TechCrunch

Goedezondag,

We hebben ‘m een keer overgeslagen, onder andere omdat Ocky op vakantie was in Zweden. In de tussentijd is er uiteraard weer veel gebeurd, dus we praten je weer even bij. Ook deze editie staat weer in het teken van kunstmatige intelligentie, een onderwerp waar we gewoon niet omheen kunnen.

Hoe zit het eigenlijk met (de rechten rondom) de data die wordt gebruikt om generatieve AI modellen te trainen?

Wat is Google van plan met AI voor hun zoekmachine?

Gelukkig is er in de Bits & Bytes wat meer variatie te vinden. Enjoy!

💽 Van wie is trainingsdata voor generatieve AI?

De data waarop grote taalmodellen getraind worden zijn een bron van discussie

Na de initiële verbazing, enthousiasme en (voor sommigen) een aantal existentiële crises over de snelle ontwikkeling die generatieve AI (zoals ChatGPT) doormaakt, lijkt het stof iets te dalen en ontstaat er ruimte voor meer debat. Eén van die debatten gaat over de data waarop deze modellen getraind zijn. Van wie is die data, mag die data gebruikt worden en hoe zit dat met persoonlijke data? Het volgende begrijp ik er tot nu toe van.

Applicaties zoals ChatGPT, Bard en Siri maken gebruik van Large Language Models (LLM’s) zoals GPT-4. Om zo’n model werkend te krijgen zijn drie dingen nodig: software, computerkracht en trainingsdata. Vaak wordt data van een ‘snapshot’ van het internet gehaald. Dat betekent praktisch gezien dat de volledige inhoud van enorm veel websites gedownload wordt om aan het model te ‘voeren’. Daarnaast creëer jij nieuwe data op het moment dat je gebruik maakt van het eindproduct. In die zin is ChatGPT een soort holle bolle Gijs.

Ik ontwaar grofweg drie problemen als het om deze trainingsdata gaat:

Copyright: in de muziek, grafische wereld en in de uitgeverij vinden een aantal partijen het problematisch dat hun output - zonder compensatie en vooral ook vaak zonder dat de auteurs dat weten - gebruikt wordt als input voor een commercieel product. De NYT beschrijft bijvoorbeeld dat discussieforum Reddit geautomatiseerde toegang (via de API) tot haar website betaald gaat maken. Shutterstock verkocht foto’s voor de training van Dall-E en de zangeres Grimes pakt het juist groots aan: iedereen mag haar muziek gebruiken om nieuwe AI-Grimes liedjes te maken als ze maar 50% van de omzet krijgt.

Kwalijke Content: trainingsdata bepaalt voor een deel het gedrag van een generatieve AI. Racistische, kwetsende of inaccurate trainingsdata is op die manier terug te zien in de output. De Washington Post publiceerde een boeiend onderzoek naar dataset van Google dat onder andere gebruikt is om Facebooks LLaMA model te trainen. De onderzoekers concludeerden dat RT.com - een Russische propagandasite - één van de grootste bijdragers was. Maar ook - in relatie tot het vorige punt - dat het copyright teken (©) tweehonderdmiljoen keer voor kwam.

Persoonlijke Perikelen: veel persoonlijke informatie is online beschikbaar en wanneer we iets persoonlijks delen met een chatbot als ChatGPT bewaart het deze informatie. Mensen hebben echter maar weinig inzicht in welke en hoe onze informatie gebruikt en opgeslagen wordt. Dit was ook de reden dat Italië vorige maand ChatGPT tijdelijk verbood en dat onder andere de Spaanse overheid een onderzoek is gestart.

De EU loopt wat betreft regulering om bovenstaande problemen aan te pakken voorop. In de Europese AI Act zijn inmiddels een aantal regels voor zowel model-makers als ontwikkelaars van generatieve AI opgenomen. Daarover later meer!

B.K.

🔍 De toekomst van Googlen

Ook Google integreert AI in de zoekmachine, maar kiest een andere aanpak dan Microsoft.

Eerder schreven we al over de grote veranderingen die AI teweeg gaat brengen voor zoekmachines en de zoekervaring op het internet. Microsoft was de eerste die een integratie van de modellen van OpenAI met zoekmachine Bing uitbracht. Ze wilden Google ‘laten dansen’. Google loopt hopeloos achter en moet aan een wanhopige inhaalslag beginnen, was toen de conclusie.

Inmiddels zijn we een paar maanden verder en heeft ook Google stappen gezet. Tijdens de jaarlijkse Google I/O toonde het bedrijf hun eigen versie van een met AI verrijkte zoekmachine. En het kiest een andere aanpak dan Microsoft. David Pierce schreef hier een goede analyse over voor The Verge.

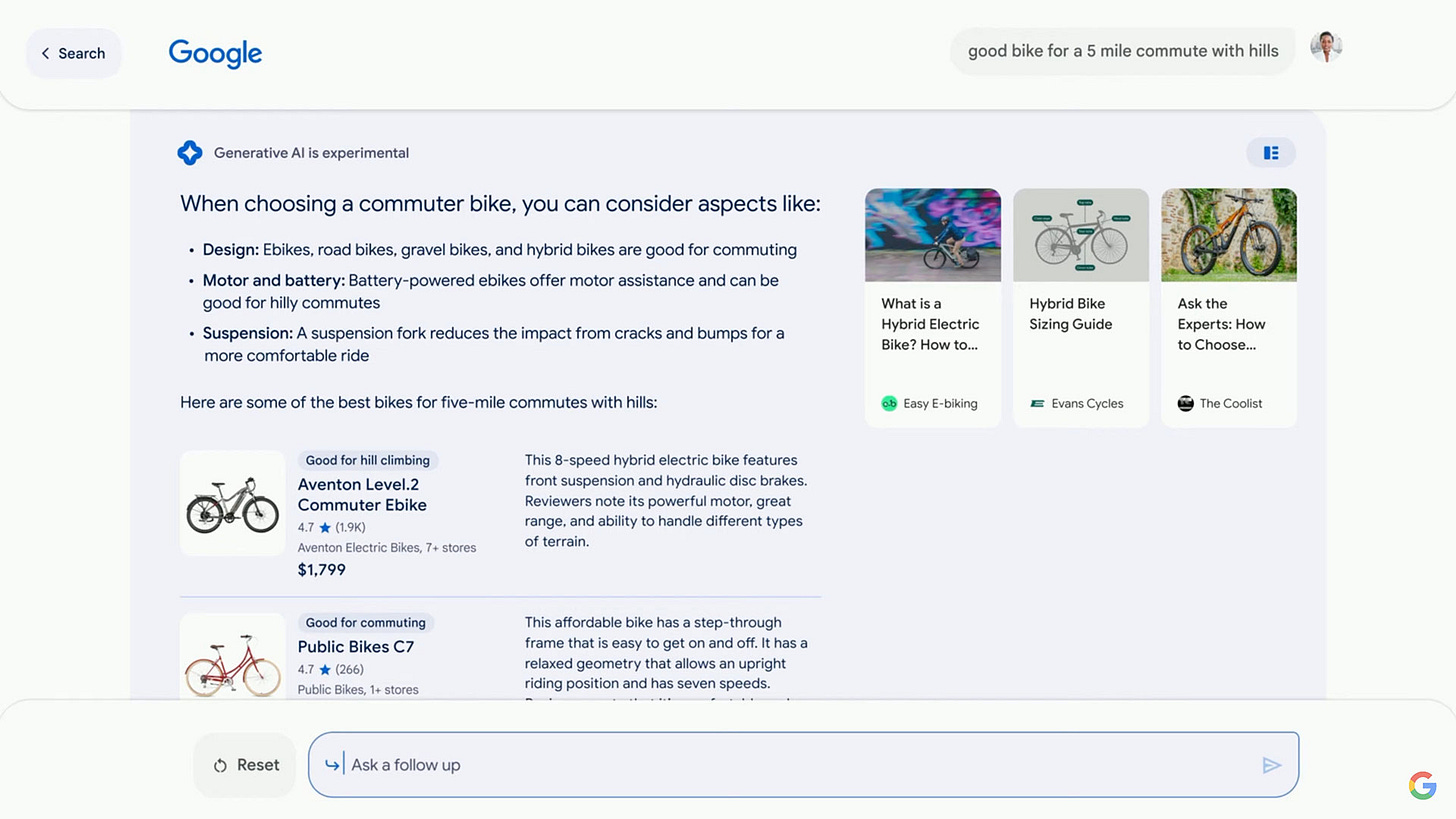

Waar Microsoft een chatbot heeft geïntegreerd, kiest Google ervoor om weg te blijven bij een chatbot-interface voor de zoekmachine. (Google heeft wel een chatbot, maar gebruikt die niet voor zoeken). In plaats daarvan plaatst het door AI verbeterde zoekresultaten bovenaan misschien wel de belangrijkste pagina op het web: Googles Search Engine Result Page.

De AI van Google Search doet zich niet ‘menselijk’ voor. Het geeft geen meningen, de resultaten worden in een neutrale toon gebracht, en het richt zich vooral op feiten. Dat is het verschil tussen ‘feitelijk’ en ‘fluïde’, waarbij Google (voorlopig) nadrukkelijk voor het eerste kiest.

Google is wat conservatiever. De door AI gegenereerde zoekresultaten worden niet automatisch getoond. Het is een optie die de gebruiker kan aanzetten. Daarnaast kiest de zoekmachine er regelmatig voor om überhaupt geen AI resultaten te tonen, bijvoorbeeld als het gaat om medische informatie.

En dan, wat is de impact van dit alles? Volgens Jay Peters, wederom van The Verge, is het de meest fundamentele verandering voor de belangrijkste pagina op het internet.

Voor gebruikers zou het een enorme verbetering kunnen zijn, maar niet in alle situaties. De fameuze blauwe linkjes die zo centraal staan (stonden?) bij Google verdwijnen naar de achtergrond. Voor mensen die ‘dieper’ willen zoeken en vooral verschillende bronnen willen raadplegen is dat niet fijn.

Voor uitgevers is de impact enorm. Als Google minder gaat doorlinken naar andere websites, verliezen uitgevers advertentie inkomsten. Uiteindelijk is dat ook slecht voor Google, want als uitgevers stoppen omdat het niet meer rendabel is, is er ook geen content meer om te doorzoeken en te aggregeren. Elger van der Wel schreef daar ook een goede analyse over.

Search was overigens niet het enige onderwerp waarover Google vernieuwingen aankondigde tijdens Google I/O. Hier een uitgebreide lijst (van Google zelf).

O.W.

💡Bits & Bytes

Een mooi voorbeeld van ‘scrollytelling’: over dark patterns op het internet.

Een veel gedeeld artikel in Wired waarin een journalist bijna poëtisch een TSMC chipfabriek beschrijft.

Wie maakt wel eens gebruik van de Pomodoro techniek? Hierbij een ondersteunend Popmodoro playlistje!

Al wat ouder, maar wij kenden ‘m nog niet: 9 manieren om de welvaart van Jeff Bezos te visualiseren.

Je wist niet dat je het nodig had: een site met luchtfoto’s van random vliegvelden.

Wetenschappers hebben de grootste ‘Schrödingers Kat’ ooit gecreëerd: een object in quantum superpositie.

Iemand heeft met behulp van AI een trailer gemaakt van The Lord of The Rings in de stijl van Wes Anderson.

De missie van Apollo 11 in real time herbeleven? Dat kan hier.

📷 Beeld van de week

Een jaar geleden publiceerden we editie #38, over de (zoveelste) crypto-crash, ambient computing, de impact van de AVG op innovatie, en onderzeese internetkabels.

Courand #38 - Cryptocrash en ‘altijd aan internet’

Het zijn gekke tijden. We moeten ons weer zorgen maken om een nieuw virus, Twitter wordt waarschijnlijk toch niet verkocht aan Elon Musk, en Matthijs van Nieuwkerk geeft op nationale televisie een NFT aan Alex Ploeg. What a time to be alive! Ondertussen lezen en schrijven wij rustig door.

Ben je hier via-via? Schrijf je in voor de nieuwbrief om elke twee weken een nieuwe editie van CouranD te ontvangen!

En, vond je dit leuk? Kan het beter? Heb je tips voor interessante onderwerpen? Laat het ons weten! Je kan gewoon mailen naar courand@substack.com. En vergeet ‘m niet te delen!

Barend en Ocky